Antes de ponernos manos a la obra con nuestros queridos RAW, necesitamos contar con un buen laboratorio fotográfico. Lejos quedan (bueno, no tan lejos, de hecho, ahí siguen) los años de costosos equipos de revelado, peligrosos productos químicos y el inefable resplandor de una bombilla roja en las tinieblas perpetuas del laboratorio tradicional. Las cosas ahora siguen siendo costosas, pero al menos podemos utilizar nuestros equipos para ver vídeos de gatos. Hoy vamos a repasar el hardware necesario para revelar fotografía digital con la premisa de la alta calidad bien presente.

Antes de comenzar, una advertencia importante. Hasta este capítulo, puedo dar fe de que todo lo que he ido describiendo en FLAC es fruto no solo de mi estudio, sino también de mi experiencia y práctica. Puedo acreditar que todo aquello de lo que hablo está contrastado por mi mismo, lo cual es la máxima garantía que puedo dar de que los contenidos de esta serie son correctos y no faltan a la verdad.

La situación en este capítulo es bien distinta. Por circunstancias que iré contando a lo largo de las siguientes líneas, mi conocimiento de lo relacionado con el hardware y otros dispositivos relacionados con la fotografía digital apenas pasa de lo meramente teórico. No creo que esto sea un hándicap invencible, pero al menos sí que me siento obligado a avisaros de que las cosas de las que a continuación voy a dar cuenta están extraídas casi en exclusividad de mis lecturas y no de mi labor práctica como fotógrafo aficionado. De forma que la garantía de verosimilitud que sostenía hasta el momento se va a ver condicionada por mis fuentes. Sirva esto de paso para reiterar mi invitación a la gente que sigue esta serie: si sabéis más que yo de esto, os doy la bienvenida a participar en la elaboración o reescritura de este capítulo, en el caso de que algunos de los contenidos no se ajusten completamente a la realidad práctica.

A este primer problema hay que añadir otro no menos importante: en esto de la fotografía digital reina cierto «clasismo» que parte de la idea preconcebida de que la fotografía no es realmente de calidad si no contamos con un equipamiento estrictamente profesional. No me cansaré de luchar contra esa idea a través de FLAC o donde sea; la alta calidad en fotografía se obtiene, en primer lugar, usando los conocimientos artísticos y la sensibilidad propia; y, en segundo, conociendo las posibilidades y, sobre todo, los límites técnicos de nuestra cámara y del resto del equipo. Los dispositivos de gama profesional, si bien son, por supuesto, altamente recomendables y proporcionan un nivel de eficacia en el flujo de trabajo incomparable, no son ni la panacea ni la clave para obtener buenas fotos. Como veremos en este artículo, lo que proporciona un buen hardware es control sobre el revelado y un flujo de trabajo más cómodo, más rápido y más exacto. Nada más. Y nada menos.

Dicho esto, que me temo que ha sonado a ponerse la venda antes de tener la herida, voy a empezar a desglosar las piezas más importantes de nuestro laboratorio digital. A grandes rasgos, el equipamiento necesario para revelar fotografía digital no difiere demasiado de cualquier equipo informático que pueda ser utilizado para otros menesteres. Un ordenador es un ordenador, y si cuenta con los periféricos mínimos ya va a poder usarse para revelar fotos. Sobre todo si usamos Linux. No obstante, los equipos diseñados para su uso como laboratorio de revelado cuentan con algunas particularidades que van a resultar clave en la elección de determinados componentes. Y en algunos casos esto va a suponer un impacto notable en nuestro presupuesto. Vamos a ir por orden.

La CPU/Torre/caja

El corazón de nuestro laboratorio no es uno de esos elementos particulares que mencionaba. Una CPU a secas (entendiendo CPU en sentido amplio, como la «caja» donde se guardan los elementos internos básicos de todo ordenador), con sus componentes básicos (dispositivo de almacenamiento, memoria RAM, tarjeta gráfica y CPU propiamente dicha) será suficiente, sin más florituras. En fotografía digital, sin embargo, puede ser conveniente que el equipo corresponda, al menos con lo que entendemos como «gama media»: que no ande falto de memoria RAM (hoy en día, y si trabajamos con RAW de tamaños grandes, no recomendaría menos de 4GB de esta preciada memoria) y con velocidad de procesamiento en CPU aceptable: No voy a dar cifras exactas, pero creo que me estoy haciendo entender: no vais a necesitar un equipo de tipo «gaming«, ni nada parecido. Pero tampoco elijáis lo más barato que encontréis, porque seguramente acabaréis teniendo problemas. Si os sirve de referencia, aquí os dejo los datos de mi equipo:

Intel® Core™ i7-4790 CPU @ 3.60GHz × 8

GeForce GTX 960/PCIe/SSE2

Disco magnético de 2 teras

SSD de 64 Gb

16 Gb de ram

Como veis, es un equipo que no está a la última, pero que tampoco «anda a pedales»; es un término medio que me sirve para todo sin problemas y que, en lo que respecta a fotografía digital, funciona de maravilla.

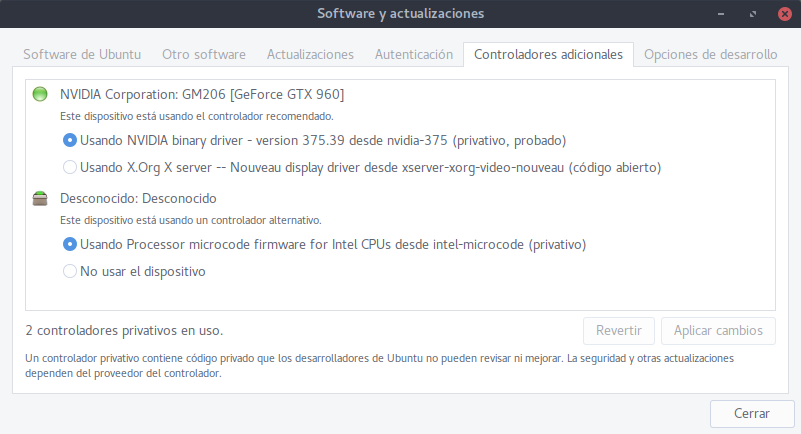

Faltan dos elementos relevantes para terminar la descripción del «cerebro» de nuestro laboratorio: la GPU y los dispositivos de almacenamiento. En cuanto a la primera (denominada también «tarjeta gráfica», aunque me voy a quedar con el primer nombre para ahorrarme caracteres, rácano que es uno), no viene de más que tengáis una gráfica dedicada, por mucho que las gráficas integradas en las placas madre de última generación tengan un rendimiento más que aceptable en la mayoría de escenarios poco exigentes. En el caso de la fotografía digital, determinadas aplicaciones cuentan con lo que se denomina «aceleración por hardware»; con esta denominación se alude a un diseño de software que permite utilizar la velocidad de procesamiento de la tarjeta gráfica para hacer cálculos, beneficiando al rendimiento global de la aplicación concreta. Varios de los programas de los que hablaré en FLAC cuentan con esta función, y lo cierto es que la diferencia en rendimiento puede ser bastante notable en algunos casos. De nuevo, y como decía antes, no va a ser necesario que os hagáis con lo último de lo último, pero sí que al menos contéis con una «gama media» decente. Eso sí, en lo que respecta a GNU-Linux, el aprovechamiento al máximo de la mejora en rendimiento que supone la activación de la aceleración por hardware va a pasar por la instalación de controladores propietarios de las tarjetas gráficas. Tened esto en cuenta si, por cuestiones éticas, no estáis dispuestos a pasar por el aro de la instalación de esta clase de programas de código cerrado.

El otro elemento relevante es la memoria de almacenamiento de datos. Aquí hay que hacer cierto balance entre tres factores: velocidad de acceso, espacio de almacenamiento y precio. Mi solución particular, que creo que soluciona esta cuestión, es la de utilizar un dispositivo de almacenamiento de alta velocidad (un disco SSD) pero de baja capacidad de almacenamiento (y menor precio también) junto a un dispositivo de tipo magnético (un disco HDD) de gran capacidad pero sustancialmente más lento (y barato).

En mi caso concreto, yo he distribuido el uso de ambos discos de la siguiente manera: el disco SSD contiene la partición del sistema (en nomenclatura Linux, la partición raíz, o simplemente «/») y el disco magnético la carpeta de mi usuario (la partición «home«). De esta manera me aseguro de varias cosas: el entorno operativo sencillamente vuela, al eliminar el cuello de botella de rendimiento que suponen los discos magnéticos. Además, tengo físicamente separados mis datos de los datos de sistema, algo muy conveniente en el caso de encontrarnos con fallas críticas de sistema que obliguen a hacer reinstalaciones urgentes. En cuanto al disco magnético, sirve de almacenamiento temporal de mis datos. Y no me cansaré de repetir lo de «temporal». Más adelante hablaré de ello, pero ya adelanto que contar con un solo dispositivo de almacenamiento para nuestros RAW, sin hacer una copia de seguridad, es sencillamente una insensatez. En el caso de que no dispongáis de unidades SSD para albergar la partición de sistema, os recomiendo que al menos contéis con dos discos duros de tipo HDD, con el mismo diseño de particiones que he mencionado. Aunque el sistema no vaya tan rápido como con un SSD, notaréis igualmente la diferencia de velocidad en la ejecución de tareas que proporciona el hecho de que haya dos discos funcionando independientemente uno de otro.

Esto en lo tocante a nuestra unidad central de cálculo. Cualquier otro aditamento será bienvenido, pero en principio no es indispensable.

El monitor (o monitores)

He aquí la madre del cordero. El monitor sí es un elemento crítico que puede diferenciar un equipo «normal» de un verdadero laboratorio fotográfico. El mundo de los monitores de ordenador es uno de esos ejemplos de cómo la industria trata de maximizar beneficios aun a costa de socavar la satisfacción de sus clientes. Ya iré detallando esta postura. De momento vamos a lo nuestro.

Los monitores son un elemento esencial en el funcionamiento de cualquier equipo informático de usuario, pues son la principal interfaz entre nosotros y la máquina. En el caso específico de la fotografía, la clave es que el monitor ofrezca una imagen lo más fiel posible a los datos que contiene el archivo que estemos editando y, sobre todo, lo más parecida posible a lo que veremos cuando nuestra imagen esté en papel. Debo insistir en este punto, para evitar una confusión frecuente: un buen monitor de fotografía no es un monitor donde la imagen se vea «más bonita» o los colores sean más vistosos. Un monitor es eso, un monitor, y no una televisión. El término «monitor» hace referencia a la función de este dispositivo de «monitorizar» la información, es decir, proporcionarnos información fiable. En el mundo del sonido ocurre lo mismo: los neófitos notarán la diferencia auditiva entre unos auriculares «normales» y unos monitores. Estos últimos suelen dar un sonido más plano, precisamente porque su función es la de ofrecer información no distorsionada. Esta fidelidad es la que garantiza que el proceso de revelado sea exacto, es decir, que los cambios que hagamos en el proceso de edición se vean idénticos en la copia en papel definitiva. Si el monitor no es capaz de ofrecer este grado de fidelidad, el revelado se hace hasta cierto punto «a ciegas», y la copia en papel nunca será exactamente igual a lo que veíamos en pantalla. Que esto sea relevante para vosotros o no, depende exclusivamente de vosotros. Ya os adelanto que yo no cuento con un monitor de fotografía profesional, ni mucho menos: es un ASUS de gama baja, sin ningún tipo de floritura ni función particularmente avanzada. Es lo que hay. Y es que aquí nos enfrentamos a uno de los obstáculos más grandes en esto del revelado digital: los precios de los monitores preparados para la fotografía son algo desorbitados, y muchas veces superan nuestros presupuestos. Este al menos es mi caso.

Si a pesar de todo estás dispuesto a realizar la inversión, voy a ir desglosando las cosas que vas a necesitar saber para elegir el monitor adecuado. Hay que tener en cuenta que, en este sentido, las tecnologías relacionadas con la visualización de imagen en pantalla están evolucionando constantemente, así que los datos y opiniones que voy a aportar a continuación corresponden con el estado de cosas tecnológico de mediados de 2017. Ahora sí, vamos por partes:

Tecnología del panel

No todos los monitores están elaborados de la misma manera. Existen, efectivamente, varias tecnologías en el mercado actual, cada una de las cuales cuenta con sus pros y sus contras: LED, IPS, Amoled, SuperAmoled… Dichas tecnologías afectan, además de a otros elementos secundarios, a la construcción del panel de imagen, esto es: la superficie donde se sitúan los millones de píxeles que constituyen lo que denominamos «pantalla» propiamente dicha, y la manera en que se iluminan. Sin adentrarnos en mayores detalles técnicos, En lo que respecta al mundo fotográfico, parece que la tecnología LED está superando en eficiencia energética y calidad a la IPS, que es la que podemos encontrar en la mayoría de pantallas de telefonía móvil y que hasta hace poco se consideraba una de las mejores en relación calidad-precio. Una de las ventajas de estos tipos de construcción de panel es el ángulo de visión: en los paneles IPS o LED el ángulo desde el que observamos la pantalla sin alteración de contraste o tonalidades es bastante grande, lo cual es una ventaja muy grande en el momento del revelado. En otro tipo de tecnologías, con ángulos más cerrados, un ligero movimiento de cabeza que nos aleje de la perpendicular del monitor puede alterar la manera en que vemos la imagen, con el consiguiente desajuste en el revelado. En este sentido, parece que la evolución del mercado nos conduce a la primacía de los paneles LED, aunque a día de hoy los paneles IPS de calidad son suficientemente solventes para aplicaciones profesionales.

Tamaño del panel

Otro aspecto que hay que tener en cuenta es el de las dimensiones del monitor. Aquí entran en juego factores de tipo ergonómico y práctico; debemos tener en cuenta que los paneles con los que trabajamos en un equipo de sobremesa se encuentran a una distancia constante de alrededor de 60 cm, por lo que procuraremos hacernos con un monitor que sea lo suficientemente grande como para no tener que forzar la vista en elementos pequeños de la imagen o las interfaces de los programas, pero no tan grande como para vernos obligados a molestos giros de cuello. En este sentido, lo dejo a vuestra elección particular, habida cuenta de que, además, existen disposiciones de escritorios con varios multimonitores, lo cual complica bastante la ecuación. Sea como fuere, el tamaño del monitor no debería, si nos movemos dentro de un rango razonable, afectar ni al visionado de la fotografía ni a su revelado.

Ratio de aspecto del panel

La forma de nuestro monitor también puede ser relevante, si de verdad queremos tener el mejor panel posible. En el mercado actual se ha impuesto casi por completo el formato panorámico en los monitores de ordenador: el largo de los mismos es considerablemente mayor que el alto, ofreciendo una forma rectangular apaisada. En mi blog personal ya despotriqué en su día sobre este asunto, que os resumo a continuación: el formato mayoritario, es decir, el 16:9 de la mayoría de los paneles, es el resultado de aplicar una política de reducción de costes en la fabricación de monitores. ¿Cómo justifico esto? Con el siguiente gráfico:

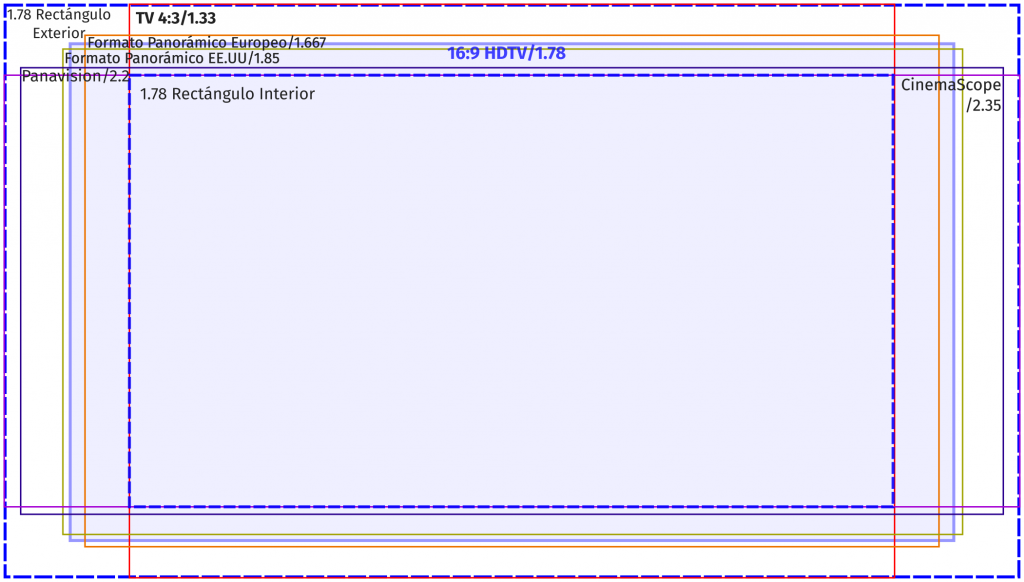

En el diseño superior podemos observar superpuestos las relaciones de aspecto fundamentales en dispositivos que proyectan imagen. Con un poco de esfuerzo podemos entender el porqué del ratio 16:9: en realidad corresponde a un compromiso de unificación de formatos. La idea corresponde al Dr. Kerns H. Powers quien en 1980 tuvo la idea de proponer este formato, en un intento de ofrecer una solución económica al desaguisado de ratios de aspecto en pantallas de cine, televisión y ordenadores. El ratio de 16:9 surge matemáticamente al superponer el resto de ratios de aspecto y trazar dos rectángulos que tengan como límites los máximos y mínimos de todos los rectángulos, tanto en altura como en longitud. A partir de ahí, se traza la distancia media entre ambos rectángulos… et voilà! obtienes como resultado una pantalla que no sirve ni para ver cine, ni para aplicaciones ofimáticas, ni mucho menos para fotografía. Cuando digo «no sirve» me refiero a que con este formato, estrecho y alargado por naturaleza, se pierde una valiosa información de altura que, en en lo que a nosotros respecta, equivale a ver las imágenes mucho mayores. Este efecto pernicioso se incrementa, claro está, con las imágenes verticales, cuya edición en este tipo de pantallas resulta dolorosa visualmente, por decir algo. Cada vez que me pongo a editar y observo el espacio que me sobra por los lados… en fin. Resumiendo mucho, lo voy a dejar en la recomendación de que, ante varias opciones de ratio de aspecto, os vayáis a por uno de 16:10 o, en situaciones ideales, un 4:3.

Resolución

Los últimos tiempos han traído al mercado una plétora de monitores con resoluciones denominadas genéricamente como «UHD» (Ultra Alta Definición». Son los denominados monitores 4K, diseñados en principio para facilitar la transición hacia el uso como dispositivos domésticos de televisores con tamaños de pantalla monstruosos. Las, en comparación, mucho más humildes resoluciones «HD», de 1920 píxeles de largo por 1080 de alto, se están quedando obsoletas poco a poco. En nuestro terreno fotográfico, sin embargo, no creo que la resolución sea un elemento a tener demasiado en cuenta, siempre y cuando partamos de un mínimo «decente», que por comodidad y economía yo situaría en los «tradicionales» 1080. En líneas generales, la experiencia de editar fotografía a 4K no parece muy diferente de hacerlo a resoluciones más humildes, salvando el hecho de que las imágenes, naturalmente, se verán más pequeñas y algunas operaciones que tradicionalmente hacíamos aumentando la imagen hasta el 100% de su tamaño, tendremos que hacerlo aumentándola hasta el 200% o más.

Evidentemente, la resolución 4K tiene sus ventajas: alguna vez me he encontrado comportándome cual personaje de cuento de Dickens, apoyando mis sucias manos sobre el escaparate de una tienda de electrodomésticos, admirado ante la calidad de imagen de las televisiones y monitores 4K, adquiridas solo por prebostes cuyas manos llenas de billetes se abalanzaban sobre aquellas joyas de la tecnología… y mi mente se cubría de nefastos nubarrones cuando imaginaba que el destino de aquellas maravillas tecnológicas sería, en el mejor de los casos, emitir ocho horas diarias de telenovelas, películas de calidad discutible, y, lo que es peor, tertulias políticas al mediodía. «Dios da pan a quien no tiene dientes», que decía mi abuela. Literatura aparte, las resoluciones altas garantizan un visionado más cómodo de lo que aparece en pantalla, especialmente la tipografía. Más píxeles por pulgada significa que todo se ve más suave, hasta que llega a desaparecer la sensación de «estar viendo píxeles». Todo lo cual contribuye a cansar menos la vista, lo cual es de agradecer. El aspecto estético de la resolución 4K, en suma, es ideal para las personas que estén delante de los monitores muchas horas diarias.

Sin embargo, todo este chorreo de píxeles tiene un precio. O mejor dicho, dos precios. El primero es el económico, y es muy alto. El segundo es un poco más técnico: mover toda esa cantidad monstruosa de píxeles se hace a costa de forzar nuestras tarjetas gráficas; no podemos pasar por alto el hecho de que una resolución de 1920 por 1080 tiene alrededor de dos millones de píxeles en pantalla, mientras que una resolución 4K de 3840 por 2160 mueve nada menos que cuatro veces más, ocho megas. Y dibujar eso al menos sesenta veces por segundo cuesta trabajo. Así que si estás pensando en adquirir una de estas preciosidades quizá sería conveniente que pensases también en renovar la GPU.

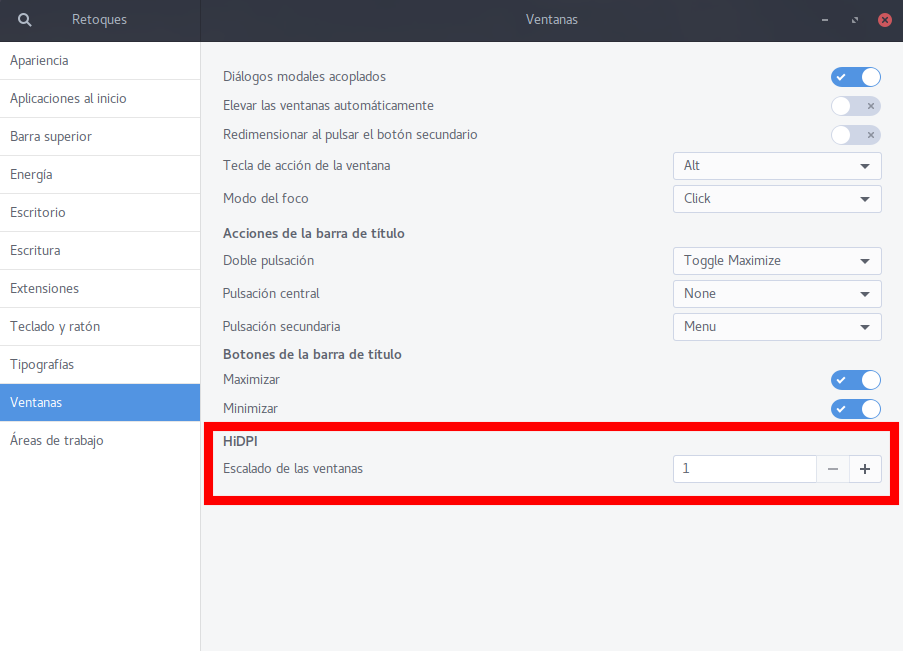

Otro problema añadido es el de cómo los sistemas operativos y las aplicaciones lidian con estos tamaños de pantalla. Antes de adquirir uno de estos monitores UHD es recomendable que te asegures de que tu sistema operativo puede gestionar su apariencia de modo que, al usar una resolución tan grande, la interfaz del sistema y, sobre todo, los textos, no se vean diminutos, haciendo difícil el trabajo efectivo con el mismo. Por suerte, la mayoría de las versiones nuevas de las distros Linux, al menos las más generalistas de ellas, cuentan con secciones de configuración (buscad cualquier apartado que se llame «HiDPI» en la configuración del sistema) que permiten hacer esta clase de adaptaciones. Pero no está de más que lo verifiques antes de llevarte sorpresas desagradables.

Profundidad de bits y tablas LUT

Aquí nos adentramos en un terreno farragoso. En capítulos anteriores ya mencionaba aquello de que nuestros archivos RAW almacenan información a 12, 14 o más bits, mientras que los archivos jpg lo hacen a 8. Esto implicaba que la edición en estos últimos fuese mucho más delicada, y tendente a la aparición de indeseables efectos de bandeado en superficies de color con degradados. Pues bien, en el terreno de los monitores la cosa se complica bastante. Resumiendo mucho, la cosa va más o menos así: nuestras GPU (las tarjetas gráficas, insisto) y nuestros monitores se comunican entre sí intercambiando lo que se denomina «tablas LUT». El término LUT corresponde con las siglas en inglés «Lookup Table«, que a su vez es un término usado en informática para referirse a tablas de computación. Dejo esto para los interesados en el asunto, que de momento a nosotros no nos toca tan de cerca (lo hará, pero en capítulos futuros). Estas tablas son básicamente un mapeado de color, que sirve a cada uno de estos dispositivos para representar los colores de acuerdo con la información que reciben de un archivo determinado. En el proceso de interpretación y representación del color, la información que recibe nuestra tarjeta gráfica es interpretada mediante una tabla LUT, y estos datos son enviados al monitor, que cuenta con su propia tabla de conversión, y la aplica de acuerdo a ella. El resultado suele ser una imagen aceptable. El caso es que hay cierta divergencia entre la manera que tienen nuestros monitores de procesar esa información, respecto a nuestras GPU. Aquellos los hacen, en la mayoría de los casos, a 8 bits, mientras que las segundas lo hacen a 10, 14, 16… según modelo. La teoría detrás de esto es que a más información procese la GPU, mejor será la calidad de imagen definitiva, aunque el monitor no llegue a mostrar tanta (no en vano, como ya hemos visto, esos 8 bits son suficientes para dar una sensación de naturalidad al ojo). Sin embargo, en los últimos tiempos han ido apareciendo modelos de monitores con profundidades de bits similares a las de las GPU, lo cual ha complicado un poco las cosas, o al menos contribuido a aumentar la confusión en torno a este particular.

Mi «veredicto», en este sentido, es el que sigue: no creo que, a día de hoy, la profundidad de bits sea relevante a la hora de revelar fotografía digital. al margen de que sea o no real la diferencia en cuanto a posibilidades de aparición de bandeo, el objetivo de un monitor de fotografía no es que «las imágenes se vean bonitas», como ya dije antes. En ese sentido, un monitor de revelado debe actuar como lo que etimológicamente evoca su propio nombre, esto es: actuando como un mero espectador objetivo más que como un intérprete benévolo. Esta aseveración parece que es apoyada por bastantes gurús del asunto en la red, así que voy a mantenerme en mis trece mientras no me saquen del error: en mi opinión, con 8 bits vamos sobrados. Y dinero que nos ahorramos.

Espacio de color

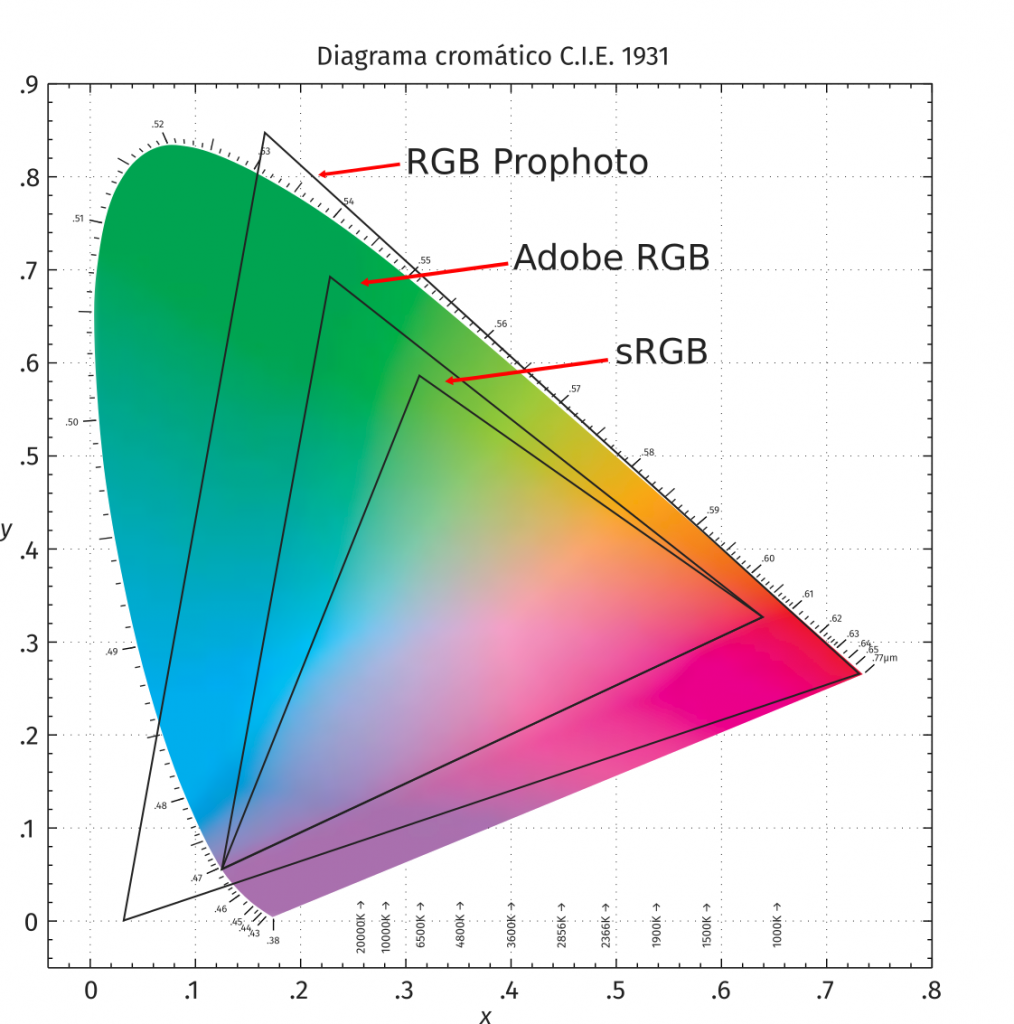

Otro tema que viene relacionado con asuntos ya tratados con anterioridad es el del espacio de color. Del mismo modo que un archivo de imagen cuenta con un espacio de color determinado, o nuestras propias cámaras cuentan con la posibilidad de elegir un espacio más o menos amplio en función de ciertas necesidades, los monitores cuentan con su propio perfil de color. Dicho perfil se mueve en torno al espacio estándar sRGB, o se acerca en torno al 100% en la mayoría de los casos, y se almacena en un archivo de perfil de color con extensión «.icc». Por otra parte, existen monitores de gama alta que aseguran acercarse al espacio de color Adobe, lo cual, como sabemos, conlleva un serio aumento de la gama tonal.

De todas formas, en términos prácticos la diferencia entre ambos espacios puede que no sea tan espectacular; volvamos a echarle un vistazo al gráfico de los espacios de color:

Lo que vemos es que, en la práctica, el espacio Adobe solo supera al sRGB en los tonos azules saturados, y, sobre todo, en la gama de tonalidades verdes. Por lo demás, no llegan a ser tan diferentes. Donde sí que encontramos una diferencia muy notable es en el espacio de color Prophoto, del que ya sabemos que incluso excede la capacidad visual humana… así que no es una opción razonable en monitores. De esta forma, nos quedamos con la diatriba entre monitor AdobeRGB o sRGB. Personalmente, creo que la diferencia entre ambos espacios no justifica la diferencia de precios entre ambos. Es cierto que perderemos cierta percepción de algunas tonalidades muy saturadas, pero (insisto), creo que el hecho de contar con estos colores no es suficiente para el desembolso que ello supone, incluso tratándose de fotografía de tipo profesional.

Calibración

Así que, al final, lo de los monitores no era para tanto… ¿o tal vez sí? Como hemos visto, el mercado está saturado de opciones sofisticadas que suelen contribuir a inflar el precio más que a aportar algún tipo de ventaja significativa para el fotógrafo. Sin embargo, sí que hay algunos elementos que pueden decantar la balanza y cuya observancia puede llegar a ser fundamental. Y no me estoy refiriendo a tecnologías sofisticadas. Más bien me refiero a la calidad global con la que está construido el monitor y, en especial, a la fidelidad real que este tiene a la hora de mostrar los colores. Este sí es el elemento crítico, pues esa fidelidad a los datos tonales de la imagen es la que nos permite saber exactamente qué es lo que estamos haciendo mientras revelamos. Si el monitor no es fiel y muestra colores distorsionados, entonces es cuando no nos será posible saber cómo quedará la fotografía en papel, y ni siquiera cómo se verá la foto en otras pantallas de mejor o peor calidad.

Es por esta razón que resulta de especial importancia el concepto de calibración de color en los monitores de ordenador dedicados a la fotografía. Calibrar un monitor supone un proceso en dos pasos: en primer lugar, evaluar cómo representa el color el dispositivo, y en segundo término ajustarlo para que lo haga de la mejor manera posible.

Es importante señalar que, de fábrica, todos los monitores están o deberían estar calibrados. Ahora bien, ocurren dos cosas: el proceso de elaboración industrial lleva a que, por razones de economía, esta calibración nativa pueda ser errónea, no lo suficientemente exacta o sencillamente no exista. Por otra parte, todos los monitores cuentan con ciertos márgenes de error en el proceso de construcción, de modo que dos monitores de un mismo modelo no se verán exactamente igual por muy calibrados que estén. El tercer problema también es de tipo comercial. Por razones estéticas, los monitores de consumo suelen tener una calibración un tanto inexacta, que tiende a enfriar un poco los colores y aumentar la saturación, lo que contribuye a que las imágenes que representan parezcan más vistosas y atractivas. Esto último puede ser la diferencia que lleve a un usuario a elegir un monitor frente a otro cuando puede comparar varios funcionando en una tienda, así que no podemos obviar que el hecho de calibrar de forma «creativa» los monitores es algo conveniente para el fabricante. Y nuestro peor enemigo como fotógrafos.

Por todo ello es por lo que se vuelve casi imprescindible hacerse con un pequeño dispositivo que nos ayudará a tener bajo control todo lo relacionado con la plasmación de los tonos en nuestros monitores: el colorímetro o calibrador.

Un colorímetro no es más que un dispositivo que, acoplado a nuestra pantalla, es capaz de definir qué cantidad de luz y en qué tono es emitida por este (evalúa los tonos, pero también los puntos negro y blanco), y al mismo tiempo, y mediante su software integrado, puede alterar los valores de emisión de luz de nuestro monitor para ajustarlo convenientemente. El resultado de este proceso será la creación de un fichero de perfil de color (el que mencionaba antes, con extesión .icc) que en adelante utilizará el monitor en sustitución del antiguo.

Aunque existen procedimientos para llevar a cabo calibraciones «manuales» mediante software, el uso de un calibrador sigue considerándose el único con la suficiente fiabilidad: no olvidemos que nuestra percepción del color es completamente subjetiva, por lo que nuestros ojos puede que no sean el mejor dispositivo para calcular si un monitor está correctamente calibrado o no. En este sentido, el uso de un mecanismo «objetivo» se vuelve fundamental… aunque sin volverse loco. No olvidemos lo siguiente: la gran mayoría de los fotógrafos actuales editan sus imágenes con el objetivo de que sean vistas por otras personas a través de otras pantallas. Reconócelo, y haz memoria: ¿cuándo fue la última vez que imprimiste una fotografía en papel? Y aunque hagas propósito de enmienda y decidas empezar a hacerlo, sigue evaluándote después de un tiempo y calculando cuántas de tus fotos pasan a formar parte de la interminable nube de unos y ceros y cuántas terminan enmarcadas y colgando de una pared. Así las cosas, y aun admitiendo que la calibración del monitor es un aspecto importante, me atrevería a decir que también podría ser conveniente «una segunda opinión», verificando que las imágenes que revelamos se verán correctamente tanto en nuestro flamante monitor calibrado como en una vulgar pantalla de teléfono, por ejemplo. Al final de este artículo trataré de aconsejar en este sentido; de momento sigo con el relato.

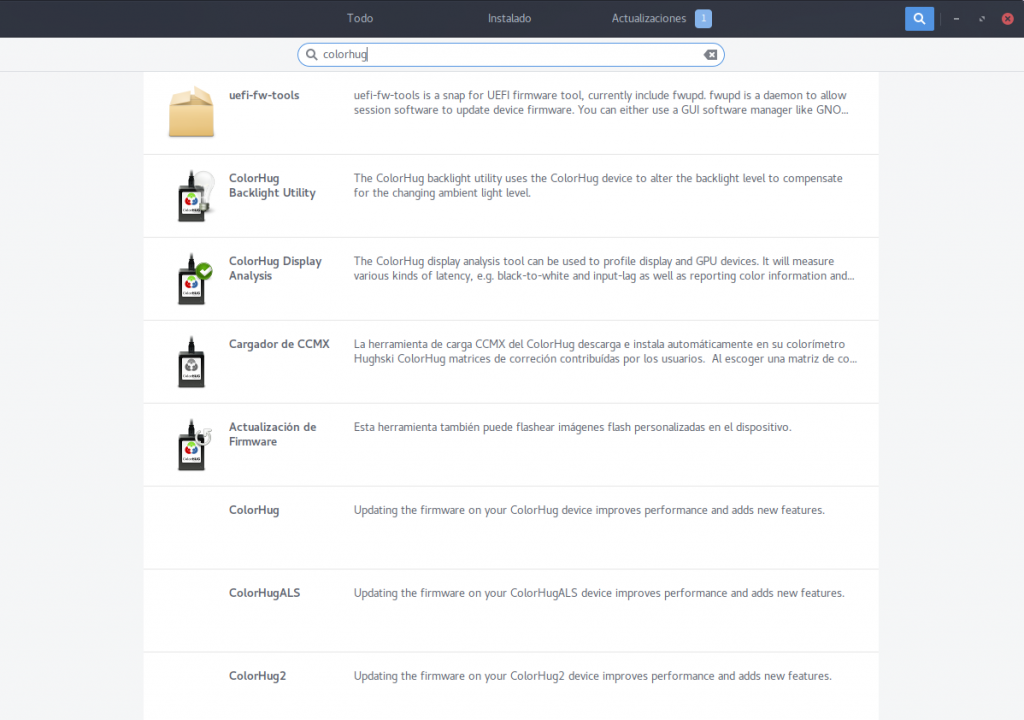

En cuanto a los aparatos disponibles en el mercado dedicados a la calibración de monitores, nos podríamos encontrar con un problema añadido: no todos ellos cuentan con el software necesario o la compatibilidad como dispositivo en entornos GNU-Linux. El problema de las compatibilidades de hardware ya no es, ni de lejos, tan grave como en los inicios del sistema del pingüino, pero sigue estando ahí con determinados componentes, y los calibradores son uno de ellos. Para curarnos en salud en este sentido, y con el ánimo añadido de contribuir un poco al movimiento del software/hardware libre, voy a atreverme a recomendaros un aparatito que puede que cumpla todas vuestras expectativas; se trata de los calibradores ColorHug, en su versión «2» o la más cara versión «+». Se trata de colorímetros construidos con especificaciones abiertas y que además no están mal de precio, aparte, cómo no, de ser completamente compatibles con sistemas Linux. Personalmente yo tengo una versión más antigua de estos calibradores, y debo decir que, aunque no les di un uso muy importante, certifico su correcto funcionamiento. Además, el software para utilizarlo se encuentra por defecto en la mayoría de repositorios de las grandes distros, así que… creo que esta es la opción definitiva para los fotógrafos libres, y que me perdonen los fabricantes de otras marcas.

Otros elementos

Para completar nuestro monitor me falta por añadir un par de cosas. En primer lugar suelo recomendar que el fotógrafo controle bien el ambiente en que va a editar la fotografía. El color del entorno y su luminosidad van a afectar a la forma en que percibimos los colores en pantalla, así que conviene que la habitación donde trabajemos tenga una fuente de luz constante, neutral y que las paredes del laboratorio no tengan dominantes que puedan contaminar la percepción. En este sentido, podría incluso recomendar la instalación de «aletas» o «viseras» en los laterales y parte superior de nuestros monitores, con el objetivo de protegerlos de fuentes de luz no deseadas:

Otro elemento a tener en cuenta es el propio diseño de nuestro centro de trabajo y la distribución de los monitores. Hoy en día son muy populares los entornos multimonitor, donde un solo ordenador muestra la imagen a través de dos o más monitores. En el caso de la fotografía este tipo de disposiciones puede resultar interesante por varias razones: en primer lugar, permite distribuir las ventanas de una forma cómoda, gozando de un mayor espacio para organizar las interfaces de las aplicaciones que estemos usando. Esto puede ser de especial relevancia en programas que permiten el desacoplado de menús, como puede ser GIMP, por ejemplo. Situar los menúes más importantes en un monitor y dedicar el otro enteramente a la previsualización de la imagen puede ser una solución perfecta cuando no queremos que otras ventanas contaminen la visualización de una imagen. Además, hay otra ventaja añadida: usando dos monitores en vez de uno podemos incluso ahorrarnos dinero, al poder permitirnos comprar monitores más pequeños y, por lo tanto, más baratos. Podéis hacer la investigación vosotros mismos, pero ya os adelanto que, en general, la combinación de «monitor barato y pequeño + monitor profesional y pequeño» suele ser más barata que la de «monitor profesional y grande» a secas. El tercer añadido, relacionado con el anterior, es que, al contar con doble monitor, y de calidades diferentes, podemos examinar rápidamente cómo se verá la imagen en un monitor «normal». Esto es especialmente relevante si nuestro principal medio de divulgación de nuestro trabajo es internet. Y en ese saco entramos casi todos últimamente.

Resumiendo

Ya veis que el tema de los monitores da bastante de si… pero también espero haber dejado constancia de que el precio de nuestras pantallas puede verse incrementado hasta el infinito debido a funciones o características que realmente no afectan al revelado digital. A grandes rasgos, mi idea sobre el monitor ideal gira en torno a estos condicionantes:

- Ergonomía: debe permitirme ver la información de manera cómoda.

- Ángulo de visión: debe ofrecer el mismo visionado desde el mayor ángulo posible, así como tener el mismo tipo de luminosidad y color en toda su superficie.

- Fidelidad: Debe mostrar los colores y la luminosidad de la forma más exacta posible.

Cumpliendo estos factores ya podemos darnos por satisfechos, pues estaremos ante un monitor suficiente para nuestro trabajo. Si queremos estar completamente seguros, podemos reducir nuestro rango de opciones a aquellos monitores que cuenten con una certificación oficial que garantice su fidelidad en la reproducción del color y la calidad de su construcción, como por ejemplo la certificación FOGRA, entre otras.

Periféricos

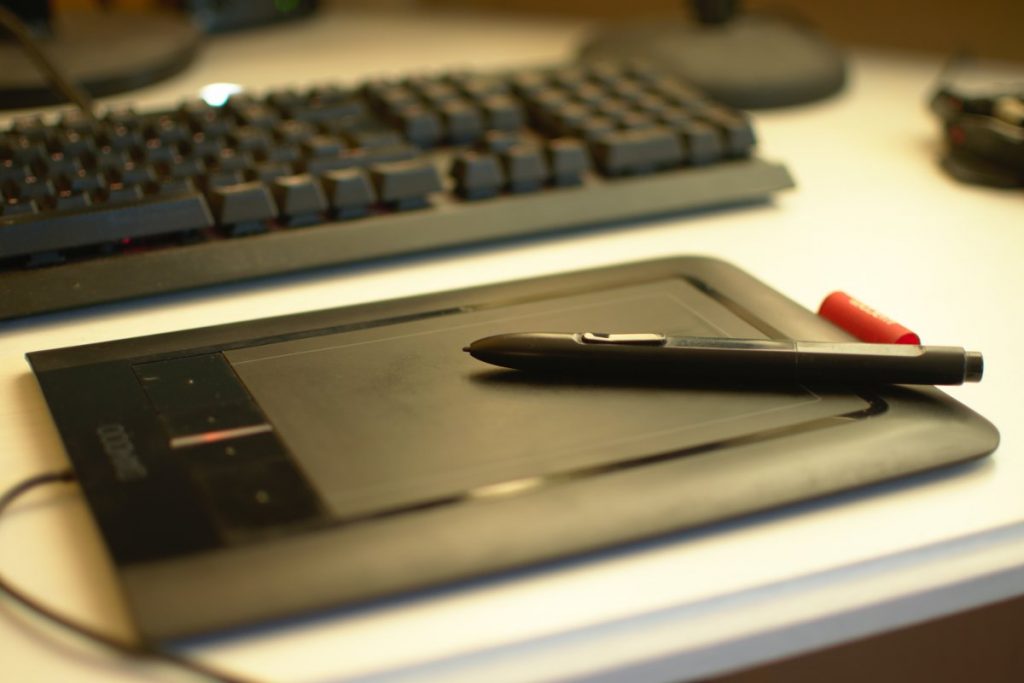

Además de nuestra CPU y nuestro monitor calibrado, vamos a tener que adquirir algún que otro componente adicional. A no ser que tengamos muy desarrollada la telequinesia, nos hará falta un teclado y un ratón, por supuesto. Y para el segmento fotográfico un lector de tarjetas es fundamental. Recomiendo uno integrado en la propia CPU, o al menos alguno que se conecte a través de interfaz 2.0 cómo mínimo. La velocidad de transferencia es la clave, así que cuanto más rápido podamos descargar nuestros archivos, mejor. Otro elemento que puede ser interesante es la tableta digitalizadora, un dispositivo con forma de… tableta, que acompañado de un instrumento semejante a un lápiz nos permite interactuar con nuestro ordenador como si estuviéramos realmente dibujando con lápices tradicionales.

Aunque fui un ferviente usuario de esta clase de dispositivos en el pasado, actualmente los he dejado un poco de lado, y me he ido acostumbrando al uso del ratón como interfaz entre el ordenador y yo. No obstante, esto depende mucho del software de edición que uséis, así que os recomiendo que os hagáis con una si vuestro programa de cabecera hace un uso intenso de pinceles y ese tipo de herramientas. En el caso de que así sea, no obstante, os recomiendo que os hagáis con una tableta pequeña. La mía es de un tamaño de A6 y es más que suficiente para fotografía, creedme. Por suerte, el soporte de este tipo de periféricos en Linux es cada vez mejor, así que casi con total probabilidad, no tendréis que temer que vuestra tableta no se lleve bien con el pingüino.

Otro elemento importante para el fotógrafo es el de los dispositivos de almacenamiento permanente, copia de seguridad o backup, como prefiráis llamarlo. De nuevo, las opciones en este campo son considerables. Particularmente opto por humildes discos duros externos de tipo magnético, que voy renovando cada varios años. De momento no he tenido problema alguno con este tipo de sistema de copia de seguridad, así que creo que puede ser una recomendación económica. Si queréis algo más sofisticado podéis optar por configuraciones de varios discos duros que hagan copias redundantes en configuraciones de tipo RAID, pero creo que esto ya entra dentro del terreno del profesionalismo puro, dado el elevado coste de estos sistemas.

Y creo que esto es todo lo que puedo decir sobre hardware relacionado con fotografía. No es un análisis demasiado profundo, pero sí que creo que cubre las inquietudes más generales de un fotógrafo novicio. y de eso se trata. En el siguiente capítulo vamos a empezar a trastear con algo de software.

Nota: Todas las imágenes, si no se indica lo contrario, son obra del autor de este artículo y se pueden usar libremente, citando la fuente. La imagen de cabecera es obra de stux, via Pixabay (CC0 Dominio Público).

![Informe 7 [+ 15] días ([8ª, 9ª y] 10ª semana de 2017)](https://colaboratorio.net/wp-content/uploads/2017/02/Informe-7-días.redimensionado-100x75.jpg)

Tremendo artículo y sobre todo muy útil. Lo de la calibración del monitor es algo que me está dando mil dolores de cabeza, sobre todo cuando llega la hora de compartir una imágen te encuentras con gente que la ve de una forma y gente que la ve de otra.

Gracias por compartir tu experiencia.

Excelentisimo!!!

Cada día seguimos aprendiendo cosas nuevas en este mundo de la fotografia libre, en el cual me he sumergido de cabeza. Sigo fielmente cada entrega.

Del laboratorio que describes me hace falta el calibrador, pues por alguna razón lo he dejado para despues y este despues se ha hecho una eternidad.

Gracias por estos articulos amigo.

Jairo

Como siempre es un placer leerte y aprender contigo. Gracias.

El artículo muy útil, como todo lo que hace @jen0f0nte.

A día de hoy Junio del 19 ¿qué cosas cambiaríais?